當人工智能(AI)能為企業達到天馬行空的目標,大型語言模型(LLMs)更為地球數十億人每天解決無數難題同時,2024 年或之後這項科技,再向前進的最大難關是甚麼?這無關演算法、編程工作以至數據中心框架的問題,而是回歸兩項最「物理層」的基本步:半導體與電源限制。

每一間站在 AI 生態度系統下的企業,對於以上問題都存在不同觀點。在努力深耕 GPT 應用模型 LLM 框架長達 6 年,在去年終於憑 ChatGPT 產品一炮而紅的 OpenAI,雖然一直屬軟件開發者身分,但希望參與半導體市場發展的意願越來越強烈。該公司行政總裁 Sam Altman 對於目前晶片生產的市場封閉而感到不滿,已屬公開秘密。早前《華爾街日報》引述消息報道,這位 OpenAI 頭目正與包括阿聯酋政府在內的投資者洽談,最終目標是籌集高達 7 萬億美元資金,以包括建廠手段提升全球晶片生產能力,直接解決 GPU 不足問題,令 AI 運算可以「鬆綁」。

目前世界上能夠生產高性能與先進製程晶片的公司不多,雖然台積電(TSMC)、三星(Samsung)、英特爾(Intel)等的名字可能大家耳熟能詳,但並非上述所有晶圓工廠都能量產針能 AI 運算環境的 GPU。半導體是一項高門欖兼巨額投資的項目,而且不同的分工與定位細緻,一般難以吸引「新人」加入。OpenAI 想從基本改革運算的未來,是非常困難,卻又無可厚非的想法。

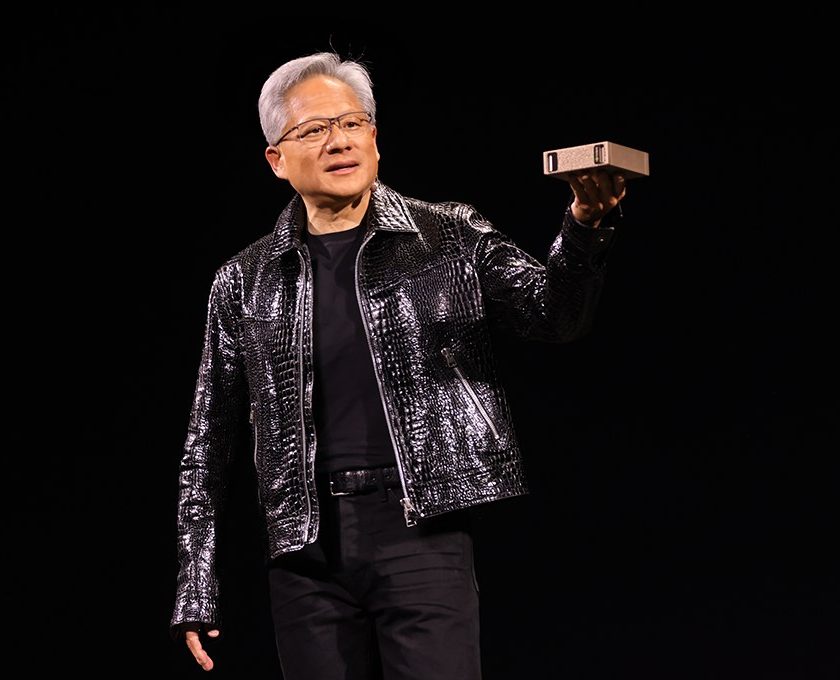

分工清晰既是半導體產業的缺點,也是部分廠商能把握的優勢。現時手執全球 AI 發展牛耳,藉 H100 GPU 強勢領導市場的 NVIDIA,與另一間近期在投資市場上備受追捧的安謀(Arm),身份同屬「無廠半導體公司」(Fabless semiconductor company),只專心設計晶片與運算架構,之後再交由晶圓工廠生產,台積電年來亦接下大量 H100 GPU 的代工業務。活在傳統半導體的體制下多年, NVIDIA 頭目黃仁勳卻認為 Sam Altman 的舉動不必要,認為業界最迫切的任務是改善 GPU 架構,而在過去 10 年 NVIDIA 已經將成功將 AI 晶片效能提升 100 萬倍,更指盲目提升產能有機會造成供應過剩的危機。

Sam Altman 與黃仁勳的觀點各有道理,也存在本身利益關係,難以分辨對與錯。不過要談到另一個「物理層」限制,即電力短缺問題相信業界任何人都沒有異議。OpenAI 的初期創辦人之一,Elon Musks 目前已經與 Sam Altman 接近反目成仇,雖然前者未能在 OpenAI 最前線的科技上再作貢獻,但他具前瞻性的長遠目光,對預估未來依然極具價值。他在 2 月底舉行的《Bosch ConnectedWorld 2024》上指出,未來兩年 AI 產業的發展樽頸,將會由「晶片不足」變成「電力缺乏」。

Elon Musks 認為世界已經渡過晶片產能不足的難關,不過 AI 與自動駕駛汽車應用持續擴張,特別是在線的 AI 運算量,每 6 個月增加 10 倍的速度看來,已經離開了目前資源限制下的可持續發展。除了全球電力不足之外,變壓器供應在未來也會出現缺乏的困局。他認為企業應該著手加強電力變壓器(voltage step-down transformers)與其他發電科技的研發,否則人類難以支撐 AI 的新科技時代。